|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

自己回帰(AR)モデルは、言語生成に大きな進歩を遂げており、画像合成のためにますます調査されています。

Autoregressive (AR) models have achieved remarkable progress in language generation and are increasingly being explored for image synthesis. However, scaling AR models to high-resolution images presents a persistent challenge. Unlike text, which requires relatively few tokens, high-resolution images necessitate thousands of tokens, leading to a quadratic growth in computational cost. As a result, most AR-based multimodal models are constrained to low or medium resolutions, limiting their utility for detailed image generation. While diffusion models have shown promising results at high resolutions, they come with their own limitations, including complex sampling procedures and slower inference. Addressing the token efficiency bottleneck in AR models remains a crucial open problem for enabling scalable and practical high-resolution image synthesis.

自己回帰(AR)モデルは、言語生成において顕著な進歩を達成しており、画像統合のためにますます調査されています。ただし、ARモデルを高解像度画像にスケーリングすると、持続的な課題が提示されます。比較的少ないトークンを必要とするテキストとは異なり、高解像度の画像は数千のトークンを必要とし、計算コストの2次成長につながります。その結果、ほとんどのARベースのマルチモーダルモデルは低解像度または中分解能に制約されており、詳細な画像生成のためにユーティリティを制限します。拡散モデルは高解像度で有望な結果を示していますが、複雑なサンプリング手順やより遅い推論など、独自の制限があります。 ARモデルのトークン効率のボトルネックに対処することは、スケーラブルで実用的な高解像度の画像合成を可能にするための重要なオープンな問題のままです。

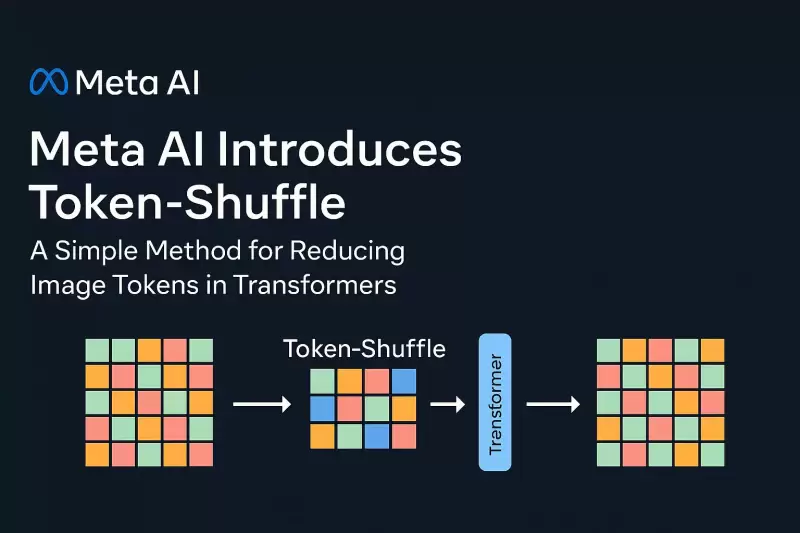

In a new contribution by Meta AI, researchers introduce Token-Shuffle, a method designed to reduce the number of image tokens processed by Transformers without altering the fundamental next-token prediction reach. The key insight underpinning Token-Shuffle is the recognition of dimensional redundancy in visual vocablies used by multimodal large language models (MLLMs). Visual tokens, typically derived from vecor quantization (VQ) models, occupy high-dimensional spaces but carry a lower intrinsic information density compared to text tokens. Token-Shuffle exploits this property by merging spatially local visual tokens along the channel dimension before Transformer processing and subsequently restoring the original spatial structure after inference. This token fusion mechanism allows AR models to handle higher resolutions with significantly reduced computational cost while maintaining visual fidelity.

Meta AIによる新しい貢献で、研究者はToken-Shuffleを導入します。これは、基本的な次のトークン予測リーチを変更せずに、変圧器によって処理される画像トークンの数を減らすために設計された方法です。トークンシャッフルを支える重要な洞察は、マルチモーダル大手言語モデル(MLLMS)で使用される視覚的なボーカブルにおける寸法冗長性の認識です。通常、VECOR量子化(VQ)モデルから導出される視覚トークンは、高次元空間を占有しますが、テキストトークンと比較してより低い内因性情報密度を持ちます。 Token-Shuffleは、変圧器処理の前にチャネル寸法に沿って空間的に局所的な視覚トークンをマージし、その後推論後に元の空間構造を復元することにより、このプロパティを悪用します。このトークン融合メカニズムにより、ARモデルは、視覚的な忠実度を維持しながら、計算コストが大幅に削減され、より高い解像度を処理できます。

Token-Shuffle consists of two operations: token-shuffle and token-unshuffle. During input preparation, spatially neighboring tokens are merged using an MLP to form a compressed token that preserves essential local information. For a shuffle window size sss, the number of tokens is reduced by a factor of s2s^2s2, leading to a substantial reduction in Transformer FLOPs. After the Transformer layers, the token-unshuffle operation reconstructs the original spatial arrangement, again assisted by lightweight MLPs.

トークンシャッフルは、トークンシャッフルとトークンアンシャッフルの2つの操作で構成されています。入力準備中、空間的に隣接するトークンは、MLPを使用してマージされ、重要なローカル情報を保持する圧縮トークンを形成します。シャッフルウィンドウサイズのSSSの場合、トークンの数はS2S^2S2の係数によって減少し、トランスフロップが大幅に減少します。変圧器層の後、トークンアンシャッフル操作は、再び軽量MLPの支援を受けて、元の空間配置を再構築します。

By compressing token sequences during Transformer computation, Token-Shuffle enables the efficient generation of high-resolution images, including those at 2048×2048 resolution. Importantly, this approach does not require modifications to the Transformer architecture itself, nor does it introduce auxiliary loss functions or pretraining of additional encoders.

Transformer計算中にトークンシーケンスを圧縮することにより、トークンシャッフルにより、2048×2048の解像度を含む高解像度画像の効率的な生成画像が可能になります。重要なことに、このアプローチでは、変圧器アーキテクチャ自体の変更を必要とせず、追加のエンコーダの補助損失関数や事前削除を導入することもありません。

Moreover, the method integrates a classifier-free guidance (CFG) scheduler specifically adapted for autoregressive generation. Rather than applying a fixed guidance scale across all tokens, the scheduler progressively adjusts guidance strength, minimizing early token artifacts and improving text-image alignment.

さらに、このメソッドは、自己回帰生成に特異的に適合した分類器フリーガイダンス(CFG)スケジューラを統合します。スケジューラは、すべてのトークンに固定ガイダンススケールを適用するのではなく、ガイダンス強度を徐々に調整し、初期のトークンアーティファクトを最小限に抑え、テキストイメージの調整を改善します。

Token-Shuffle was evaluated on two major benchmarks: GenAI-Bench and GenEval. On GenAI-Bench, using a 2.7B parameter LLaMA-based model, Token-Shuffle achieved a VQAScore of 0.77 on “hard” prompts, outperforming other autoregressive models such as LlamaGen by a margin of +0.18 and diffusion models like LDM by +0.15. In the GenEval benchmark, it attained an overall score of 0.62, setting a new baseline for AR models operating in the discrete token regime.

トークンシャッフルは、2つの主要なベンチマークで評価されました:Genai-benchとGeneval。 2.7Bパラメーターラマベースのモデルを使用して、Genai-Benchでは、Token-Shuffleは「ハード」プロンプトで0.77のVQASCOREを達成し、LMAGENなどの他の自己回復モデルを+0.18のマージンとLDMのような拡散モデルで+0.15で上回りました。 Geneval Benchmarkでは、0.62の全体的なスコアを達成し、離散トークンレジームで動作するARモデルの新しいベースラインを設定しました。

Large-scale human evaluation on two benchmarks, GenAI-Bench and GenEval

2つのベンチマークでの大規模な人間の評価、genai-benchとgeneval

Furthermore, Token-Shuffle was subjected to large-scale human evaluation on two benchmarks, GenAI-Bench and GenEval. The results indicated that compared to LlamaGen, Lumina-mGPT, and diffusion baselines, Token-Shuffle showed improved alignment with textual prompts, reduced visual flaws, and higher subjective image quality in most cases. However, minor degradation in logical consistency was observed relative to diffusion models, suggesting avenues for further refinement.

さらに、トークンシャッフルは、Genai-BenchとGenevalの2つのベンチマークで大規模な人間の評価を受けました。結果は、Llamagen、Lumina-Mgpt、および拡散ベースラインと比較して、トークンシャッフルは、ほとんどの場合、テキストプロンプトとの調整、視覚的欠陥の減少、およびより高い主観的な画質を示すことを示しています。しかし、論理的一貫性の軽微な分解が拡散モデルと比較して観察され、さらなる改良の手段が示唆されました。

In terms of visual quality, Token-Shuffle demonstrated the capability to produce detailed and coherent 1024×1024 and 2048×2048 images. Ablation studies revealed that smaller shuffle window sizes (e.g., 2×2) offered the best trade-off between computational efficiency and output quality. Larger window sizes provided additional speedups but introduced minor losses in fine-grained detail.

視覚的な品質の観点から、Token-Shuffleは、詳細でコヒーレントな1024×1024および2048×2048の画像を生成する能力を実証しました。アブレーションの研究により、シャッフルの窓のサイズが小さいこと(たとえば、2×2)が、計算効率と出力品質の間の最高のトレードオフを提供することが明らかになりました。ウィンドウサイズが大きいと、追加のスピードアップが提供されましたが、細粒の詳細でマイナーな損失を導入しました。

All in all, the researchers present a simple yet effective method to address the scalability limitations of autoregressive image generation. By merging spatially local visual tokens during the Transformer computation, their approach reduces the computational complexity without altering the fundamental next-token prediction step. This integration of spatial compression with standard AR generation is compatible with existing multimodal generation frameworks, enabling the efficient generation of high-resolution images. The experimental results highlight the potential of Token-Shuffle to push AR models beyond prior resolution limits, making high-fidelity, high-resolution generation more practical and accessible.

全体として、研究者は、自己回帰画像生成のスケーラビリティの制限に対処するためのシンプルで効果的な方法を提示します。変圧器の計算中に空間的に局所的な視覚トークンをマージすることにより、そのアプローチは、基本的な次のトークン予測ステップを変更することなく、計算の複雑さを減らします。空間圧縮と標準のAR生成のこの統合は、既存のマルチモーダル生成フレームワークと互換性があり、高解像度画像の効率的な生成を可能にします。実験結果は、トークンシャッフルの可能性が以前の解像度の制限を超えてARモデルをプッシュし、高忠実度、高解像度の生成をより実用的でアクセスしやすくする可能性を強調しています。

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。