|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

Token-Shuffle: Skalierung autoregressive Modelle zu hochauflösenden Bildern

Apr 26, 2025 at 12:38 pm

Autoregressive (AR) -Modelle haben erhebliche Fortschritte bei der Sprachgenerierung erzielt und werden zunehmend für die Bildsynthese untersucht.

Autoregressive (AR) models have achieved remarkable progress in language generation and are increasingly being explored for image synthesis. However, scaling AR models to high-resolution images presents a persistent challenge. Unlike text, which requires relatively few tokens, high-resolution images necessitate thousands of tokens, leading to a quadratic growth in computational cost. As a result, most AR-based multimodal models are constrained to low or medium resolutions, limiting their utility for detailed image generation. While diffusion models have shown promising results at high resolutions, they come with their own limitations, including complex sampling procedures and slower inference. Addressing the token efficiency bottleneck in AR models remains a crucial open problem for enabling scalable and practical high-resolution image synthesis.

Autoregressive (AR) -Modelle haben einen bemerkenswerten Fortschritt in der Spracherzeugung erzielt und werden zunehmend für die Bildsynthese untersucht. Die Skalierung von AR-Modellen zu hochauflösenden Bildern stellt jedoch eine anhaltende Herausforderung dar. Im Gegensatz zu Text, der relativ wenige Token erfordert, müssen hochauflösende Bilder Tausende von Token erfordern, was zu einem quadratischen Wachstum der Rechenkosten führt. Infolgedessen werden die meisten AR-basierten multimodalen Modelle auf niedrige oder mittlere Auflösungen beschränkt, wodurch deren Nützlichkeit für die detaillierte Bilderzeugung eingeschränkt wird. Während Diffusionsmodelle bei hohen Auflösungen vielversprechende Ergebnisse gezeigt haben, haben sie ihre eigenen Einschränkungen, einschließlich komplexer Stichprobenverfahren und langsamerer Inferenz. Die Bekämpfung des Engpässe des Token-Effizienz in AR-Modellen bleibt ein entscheidendes offenes Problem, um die skalierbare und praktische hochauflösende Bildsynthese zu ermöglichen.

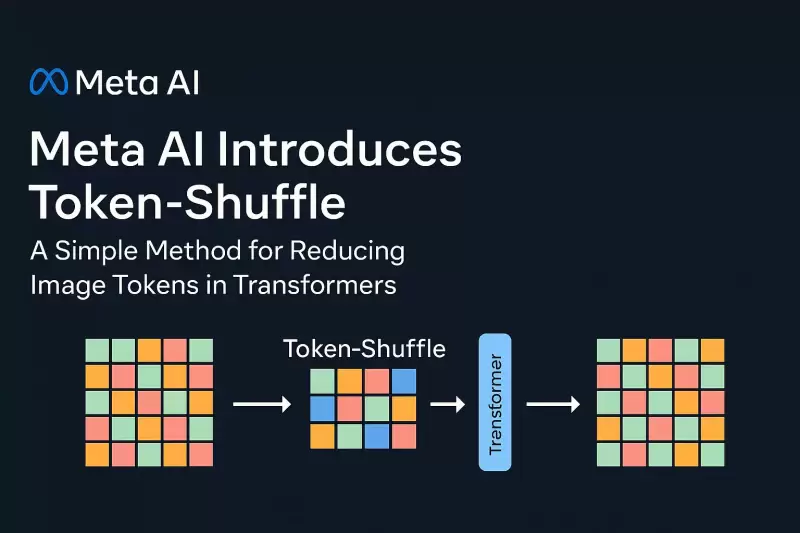

In a new contribution by Meta AI, researchers introduce Token-Shuffle, a method designed to reduce the number of image tokens processed by Transformers without altering the fundamental next-token prediction reach. The key insight underpinning Token-Shuffle is the recognition of dimensional redundancy in visual vocablies used by multimodal large language models (MLLMs). Visual tokens, typically derived from vecor quantization (VQ) models, occupy high-dimensional spaces but carry a lower intrinsic information density compared to text tokens. Token-Shuffle exploits this property by merging spatially local visual tokens along the channel dimension before Transformer processing and subsequently restoring the original spatial structure after inference. This token fusion mechanism allows AR models to handle higher resolutions with significantly reduced computational cost while maintaining visual fidelity.

In einem neuen Beitrag von Meta AI führen Forscher eine Token-Shuffle ein, eine Methode zur Reduzierung der Anzahl der von Transformatoren verarbeiteten Bildtoken, ohne die grundlegende Reichweite der nächsten Vorhersage zu verändern. Die wichtigste Erkenntnisuntersuchung der Token-Shuffle ist die Erkennung von dimensionalen Redundanz in visuellen Gesangsbereichen, die von multimodalen Großsprachenmodellen (MLLMS) verwendet werden. Visuelle Token, die typischerweise aus VQ-Modellen (VQ) von Vecor Quantisierung (VQ) abgeleitet sind, nehmen hochdimensionale Räume ein, tragen jedoch eine niedrigere intrinsische Informationsdichte im Vergleich zu Text-Token. Die Token-Shuffle nutzt diese Eigenschaft, indem sie räumlich lokale visuelle Token entlang der Kanaldimension verschmelzen, bevor die Transformatorverarbeitung und anschließend die ursprüngliche räumliche Struktur nach Inferenz wiederhergestellt wird. Dieser Token -Fusionsmechanismus ermöglicht es AR -Modellen, höhere Auflösungen mit erheblichen Rechenkosten zu bewältigen und gleichzeitig die visuelle Treue beizubehalten.

Token-Shuffle consists of two operations: token-shuffle and token-unshuffle. During input preparation, spatially neighboring tokens are merged using an MLP to form a compressed token that preserves essential local information. For a shuffle window size sss, the number of tokens is reduced by a factor of s2s^2s2, leading to a substantial reduction in Transformer FLOPs. After the Transformer layers, the token-unshuffle operation reconstructs the original spatial arrangement, again assisted by lightweight MLPs.

Token-Shuffle besteht aus zwei Operationen: Token-Shuffle und Token-nicht. Während der Eingabevorbereitung werden räumlich benachbarte Token mit einem MLP zusammengeführt, um ein komprimiertes Token zu bilden, das wesentliche lokale Informationen bewahrt. Für eine SSS der Shuffle -Fenstergröße wird die Anzahl der Token um den Faktor von S2S^2S2 reduziert, was zu einer erheblichen Verringerung der Transformator -Flops führt. Nach den Transformatorschichten rekonstruiert der Token-nicht-nicht-Betrieb die ursprüngliche räumliche Anordnung, die erneut durch leichte MLPs unterstützt wird.

By compressing token sequences during Transformer computation, Token-Shuffle enables the efficient generation of high-resolution images, including those at 2048×2048 resolution. Importantly, this approach does not require modifications to the Transformer architecture itself, nor does it introduce auxiliary loss functions or pretraining of additional encoders.

Durch die Komprimierung von Token-Sequenzen während der Transformatorberechnung ermöglicht die Token-Shuffle die effiziente Erzeugung hochauflösender Bilder, einschließlich solcher bei der Auflösung von 2048 × 2048. Wichtig ist, dass dieser Ansatz keine Änderungen an der Transformatorarchitektur selbst erfordert, und er führt auch nicht zu Hilfsverlustfunktionen oder der Vorbereitung zusätzlicher Encoder.

Moreover, the method integrates a classifier-free guidance (CFG) scheduler specifically adapted for autoregressive generation. Rather than applying a fixed guidance scale across all tokens, the scheduler progressively adjusts guidance strength, minimizing early token artifacts and improving text-image alignment.

Darüber hinaus integriert die Methode einen CFG-Scheduler (Klassifikator-Free Guidance), der speziell für die autoregressive Generation angepasst ist. Anstatt eine feste Leitlinienskala für alle Token anzuwenden, passt der Scheduler die Leitfadenstärke schrittweise an, minimiert frühe Token-Artefakte und die Verbesserung der Ausrichtung der Textbild.

Token-Shuffle was evaluated on two major benchmarks: GenAI-Bench and GenEval. On GenAI-Bench, using a 2.7B parameter LLaMA-based model, Token-Shuffle achieved a VQAScore of 0.77 on “hard” prompts, outperforming other autoregressive models such as LlamaGen by a margin of +0.18 and diffusion models like LDM by +0.15. In the GenEval benchmark, it attained an overall score of 0.62, setting a new baseline for AR models operating in the discrete token regime.

Die Token-Shuffle wurde an zwei großen Benchmarks bewertet: Genai-Bench und Geneval. Auf Genai-Bench erzielte Token-Shuffle unter Verwendung eines 2,7B-Parameter-Lama-basierten Modells einen Vqascore von 0,77 auf „harten“ Aufforderungen und übertraf andere autoregressive Modelle wie Lamagen mit einem Rand von +0,18 und Diffusionsmodellen wie LDM um +0.15. In der Geneal -Benchmark erreichte es einen Gesamtwert von 0,62 und legte eine neue Basis für AR -Modelle fest, die im diskreten Token -Regime tätig sind.

Large-scale human evaluation on two benchmarks, GenAI-Bench and GenEval

Große menschliche Bewertung auf zwei Benchmarks, Genai-Bench und Geneval

Furthermore, Token-Shuffle was subjected to large-scale human evaluation on two benchmarks, GenAI-Bench and GenEval. The results indicated that compared to LlamaGen, Lumina-mGPT, and diffusion baselines, Token-Shuffle showed improved alignment with textual prompts, reduced visual flaws, and higher subjective image quality in most cases. However, minor degradation in logical consistency was observed relative to diffusion models, suggesting avenues for further refinement.

Darüber hinaus wurde die Token-Shuffle einer groß angelegten menschlichen Bewertung an zwei Benchmarks unterzogen, Genai-Bench und Geneval. Die Ergebnisse zeigten, dass die Token-Shuffle im Vergleich zu Lamagen-, Lumina-MGPT- und Diffusionsbasis in den meisten Fällen eine verbesserte Ausrichtung mit textlichen Eingabeaufforderungen, reduzierten visuellen Mängel und höherer subjektiver Bildqualität zeigte. Ein geringfügiger Abbau der logischen Konsistenz wurde jedoch relativ zu Diffusionsmodellen beobachtet, was auf Wege für die weitere Verfeinerung hinweist.

In terms of visual quality, Token-Shuffle demonstrated the capability to produce detailed and coherent 1024×1024 and 2048×2048 images. Ablation studies revealed that smaller shuffle window sizes (e.g., 2×2) offered the best trade-off between computational efficiency and output quality. Larger window sizes provided additional speedups but introduced minor losses in fine-grained detail.

In Bezug auf die visuelle Qualität zeigte Token-Shuffle die Fähigkeit, detaillierte und kohärente 1024 × 1024 und 2048 × 2048 Bilder zu erzeugen. Ablationsstudien zeigten, dass kleinere Shuffle-Fenstergrößen (z. B. 2 × 2) den besten Kompromiss zwischen Recheneffizienz und Ausgangsqualität boten. Größere Fenstergrößen lieferten zusätzliche Beschleunigungen, führten jedoch geringfügige Verluste in feinkörnigen Details ein.

All in all, the researchers present a simple yet effective method to address the scalability limitations of autoregressive image generation. By merging spatially local visual tokens during the Transformer computation, their approach reduces the computational complexity without altering the fundamental next-token prediction step. This integration of spatial compression with standard AR generation is compatible with existing multimodal generation frameworks, enabling the efficient generation of high-resolution images. The experimental results highlight the potential of Token-Shuffle to push AR models beyond prior resolution limits, making high-fidelity, high-resolution generation more practical and accessible.

Insgesamt präsentieren die Forscher eine einfache und dennoch effektive Methode, um die Skalierbarkeitsbeschränkungen der autoregressiven Bildgenerierung anzugehen. Durch das Zusammenführen räumlich lokaler visueller Token während der Transformatorberechnung reduziert ihr Ansatz die rechnerische Komplexität, ohne den wesentlichen Vorhersageschritt der nächsten gegnerischen Vorhersage zu verändern. Diese Integration der räumlichen Komprimierung in die Standard-AR-Erzeugung ist mit vorhandenen multimodalen Generierungsrahmen kompatibel, wodurch die effiziente Erzeugung hochauflösender Bilder ermöglicht wird. Die experimentellen Ergebnisse unterstreichen das Potenzial von Token-Shuffle, um AR-Modelle über vorherige Auflösungsgrenzen hinaus zu überschreiten, wodurch eine hochauflösende und hochauflösende Erzeugung praktischer und zugänglicher wird.

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

-

-

- Von obdachlos zum Hausbesitzer: ein Ring, eine gute Tat und ein Leben verändert sich

- Aug 01, 2025 at 05:47 am

- Erkunden Sie die herzerwärmende Geschichte von Billy Ray Harris, einem Obdachlosen, dessen Ehrlichkeit einen verlorenen Ring in eine lebensverändernde Gelegenheit verwandelte und gleichzeitig das breitere Problem der Obdachlosigkeit ablegte.

-

-

-

-

-

- Spartaner, Sportwetten und der Spitzenplatz: Eine neue Ära des Krypto -Glücksspiels

- Aug 01, 2025 at 04:00 am

- Spartans.com schüttelt die Sportwettenszene mit kryptoorientierten Funktionen, schnellen Auszahlungen und aufregenden Crashspielen, die traditionelle Plattformen für den Spitzenplatz herausfordern.

-