|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

자동 회귀 (AR) 모델은 언어 생성에서 상당한 발전을 이루었으며 이미지 합성을 위해 점점 더 탐구되고 있습니다.

Autoregressive (AR) models have achieved remarkable progress in language generation and are increasingly being explored for image synthesis. However, scaling AR models to high-resolution images presents a persistent challenge. Unlike text, which requires relatively few tokens, high-resolution images necessitate thousands of tokens, leading to a quadratic growth in computational cost. As a result, most AR-based multimodal models are constrained to low or medium resolutions, limiting their utility for detailed image generation. While diffusion models have shown promising results at high resolutions, they come with their own limitations, including complex sampling procedures and slower inference. Addressing the token efficiency bottleneck in AR models remains a crucial open problem for enabling scalable and practical high-resolution image synthesis.

자동 회귀 (AR) 모델은 언어 생성에서 놀라운 진전을 달성했으며 이미지 합성을 위해 점점 더 탐구되고 있습니다. 그러나 AR 모델을 고해상도 이미지로 스케일링하는 것은 지속적인 도전을 제시합니다. 비교적 적은 토큰이 필요한 텍스트와 달리 고해상도 이미지에는 수천 개의 토큰이 필요하므로 계산 비용이 2 차 성장을 일으 킵니다. 결과적으로 대부분의 AR 기반 멀티 모달 모델은 저 또는 중간 해상도로 제한되어 상세한 이미지 생성에 대한 유틸리티를 제한합니다. 확산 모델은 높은 해상도에서 유망한 결과를 보여 주었지만 복잡한 샘플링 절차와 느린 추론을 포함하여 자체 한계가 있습니다. AR 모델에서 토큰 효율성 병목 현상을 해결하는 것은 확장 가능하고 실용적인 고해상도 이미지 합성을 가능하게하는 데 중요한 문제로 남아 있습니다.

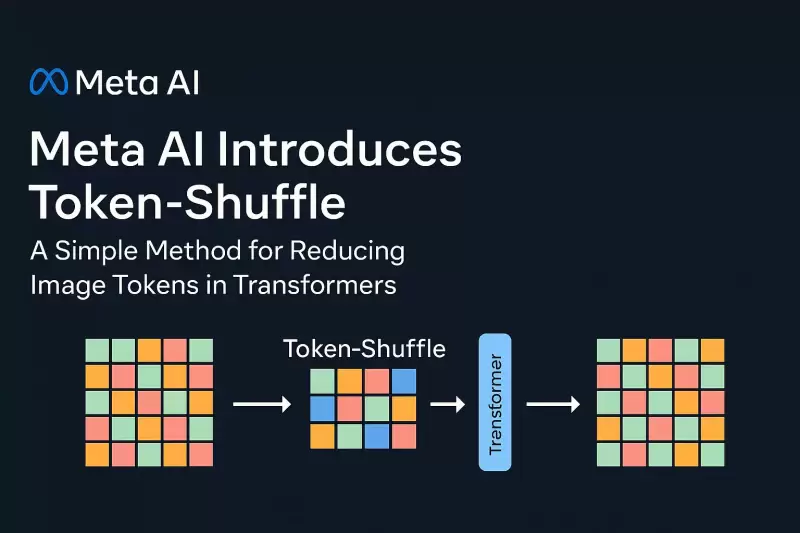

In a new contribution by Meta AI, researchers introduce Token-Shuffle, a method designed to reduce the number of image tokens processed by Transformers without altering the fundamental next-token prediction reach. The key insight underpinning Token-Shuffle is the recognition of dimensional redundancy in visual vocablies used by multimodal large language models (MLLMs). Visual tokens, typically derived from vecor quantization (VQ) models, occupy high-dimensional spaces but carry a lower intrinsic information density compared to text tokens. Token-Shuffle exploits this property by merging spatially local visual tokens along the channel dimension before Transformer processing and subsequently restoring the original spatial structure after inference. This token fusion mechanism allows AR models to handle higher resolutions with significantly reduced computational cost while maintaining visual fidelity.

Meta AI의 새로운 기여에서 연구원들은 기본적인 차세대 예측 범위를 변경하지 않고 변압기로 처리 된 이미지 토큰의 수를 줄이기 위해 설계된 토큰 셔프를 소개합니다. 토큰 셔프를 뒷받침하는 주요 통찰력은 MLLM (Multimodal Lange Language Models)이 사용하는 시각적 성적에서 치수 중복성을 인식하는 것입니다. 일반적으로 Vecor Quantization (VQ) 모델에서 파생 된 시각적 토큰은 고차원 공간을 차지하지만 텍스트 토큰에 비해 고유 한 정보 밀도가 낮습니다. 토큰 셔플은 변압기 처리 전에 채널 차원을 따라 공간적으로 로컬 시각 토큰을 병합하여 추론 후 원래 공간 구조를 복원 하여이 속성을 이용합니다. 이 토큰 융합 메커니즘을 통해 AR 모델은 시각적 충실도를 유지하면서 계산 비용이 크게 줄어든 해상도를 처리 할 수 있습니다.

Token-Shuffle consists of two operations: token-shuffle and token-unshuffle. During input preparation, spatially neighboring tokens are merged using an MLP to form a compressed token that preserves essential local information. For a shuffle window size sss, the number of tokens is reduced by a factor of s2s^2s2, leading to a substantial reduction in Transformer FLOPs. After the Transformer layers, the token-unshuffle operation reconstructs the original spatial arrangement, again assisted by lightweight MLPs.

토큰 셔플은 토큰 셔플과 토큰 유도의 두 가지 작업으로 구성됩니다. 입력 준비 동안, 공간적으로 인접한 토큰은 MLP를 사용하여 병합되어 필수 지역 정보를 보존하는 압축 토큰을 형성합니다. 셔플 윈도우 크기 SSS의 경우, 토큰의 수는 S2S^2S2의 계수만큼 감소하여 변압기 플롭의 상당한 감소를 초래합니다. 변압기 층 후, 토큰 유도 연산은 원래의 공간 배열을 재구성하여 가벼운 MLP에 의해 다시 도움이된다.

By compressing token sequences during Transformer computation, Token-Shuffle enables the efficient generation of high-resolution images, including those at 2048×2048 resolution. Importantly, this approach does not require modifications to the Transformer architecture itself, nor does it introduce auxiliary loss functions or pretraining of additional encoders.

변압기 계산 동안 토큰 시퀀스를 압축함으로써, 토큰 셔플은 2048 × 2048 해상도를 포함하여 고해상도 이미지의 효율적인 생성을 가능하게합니다. 중요하게도,이 접근법은 변압기 아키텍처 자체에 대한 수정이 필요하지 않으며, 보조 손실 기능 또는 추가 인코더의 사전 조정을 도입하지도 않습니다.

Moreover, the method integrates a classifier-free guidance (CFG) scheduler specifically adapted for autoregressive generation. Rather than applying a fixed guidance scale across all tokens, the scheduler progressively adjusts guidance strength, minimizing early token artifacts and improving text-image alignment.

또한,이 방법은 자동 회귀 생성을 위해 특별히 적응 된 CFG (Classifier-Free Guidance) 스케줄러를 통합합니다. 스케줄러는 모든 토큰에 걸쳐 고정 된 지침 척도를 적용하는 대신 점진적으로지도 강도를 조정하여 초기 토큰 아티팩트를 최소화하고 텍스트 이미지 정렬을 향상시킵니다.

Token-Shuffle was evaluated on two major benchmarks: GenAI-Bench and GenEval. On GenAI-Bench, using a 2.7B parameter LLaMA-based model, Token-Shuffle achieved a VQAScore of 0.77 on “hard” prompts, outperforming other autoregressive models such as LlamaGen by a margin of +0.18 and diffusion models like LDM by +0.15. In the GenEval benchmark, it attained an overall score of 0.62, setting a new baseline for AR models operating in the discrete token regime.

토큰 셔플은 Genai-Bench와 Geneval의 두 가지 주요 벤치 마크에서 평가되었습니다. Genai-Bench에서 2.7b 매개 변수 라마 기반 모델을 사용하여 Token Shuffle은 "Hard"프롬프트에서 0.77의 vqascore를 달성하여 Llamagen과 같은 다른 자동 회귀 모델을 +0.18의 마진과 +0.15의 LDM과 같은 확산 모델보다 우수했습니다. Geneval 벤치 마크에서, 그것은 전체 점수 0.62를 달성하여 개별 토큰 체제에서 작동하는 AR 모델에 대한 새로운 기준선을 설정했습니다.

Large-scale human evaluation on two benchmarks, GenAI-Bench and GenEval

Genai-Bench와 Geneval의 두 벤치 마크에 대한 대규모 인간 평가

Furthermore, Token-Shuffle was subjected to large-scale human evaluation on two benchmarks, GenAI-Bench and GenEval. The results indicated that compared to LlamaGen, Lumina-mGPT, and diffusion baselines, Token-Shuffle showed improved alignment with textual prompts, reduced visual flaws, and higher subjective image quality in most cases. However, minor degradation in logical consistency was observed relative to diffusion models, suggesting avenues for further refinement.

또한, 토큰 셔플은 Genai-Bench와 Geneval의 두 벤치 마크에서 대규모 인간 평가를 받았다. 결과는 Llamagen, Lumina-MGPT 및 확산 기준에 비해 대부분의 경우 텍스트 프롬프트, 시각적 결함 감소 및 더 높은 주관적 이미지 품질과의 정렬이 개선 된 것으로 나타났습니다. 그러나, 확산 모델에 비해 논리적 일관성의 작은 분해가 관찰되었으며, 추가 정제를위한 길을 제안했다.

In terms of visual quality, Token-Shuffle demonstrated the capability to produce detailed and coherent 1024×1024 and 2048×2048 images. Ablation studies revealed that smaller shuffle window sizes (e.g., 2×2) offered the best trade-off between computational efficiency and output quality. Larger window sizes provided additional speedups but introduced minor losses in fine-grained detail.

시각적 품질 측면에서, 토큰 셔플은 상세하고 일관된 1024 × 1024 및 2048 × 2048 이미지를 생성하는 능력을 보여 주었다. Ablation 연구에 따르면 작은 셔플 윈도우 크기 (예 : 2 × 2)는 계산 효율과 출력 품질 사이에 최상의 트레이드 오프를 제공하는 것으로 나타났습니다. 더 큰 창 크기는 추가 속도를 제공했지만 세밀한 세부 사항으로 경미한 손실을 도입했습니다.

All in all, the researchers present a simple yet effective method to address the scalability limitations of autoregressive image generation. By merging spatially local visual tokens during the Transformer computation, their approach reduces the computational complexity without altering the fundamental next-token prediction step. This integration of spatial compression with standard AR generation is compatible with existing multimodal generation frameworks, enabling the efficient generation of high-resolution images. The experimental results highlight the potential of Token-Shuffle to push AR models beyond prior resolution limits, making high-fidelity, high-resolution generation more practical and accessible.

대체로 연구원들은자가 회귀 이미지 생성의 확장 성 제한을 해결하기위한 간단하면서도 효과적인 방법을 제시합니다. 변압기 계산 중 공간적으로 국소 시각적 토큰을 병합함으로써, 그들의 접근 방식은 기본 다음 차기 예측 단계를 변경하지 않고 계산 복잡성을 줄입니다. 이러한 공간 압축과 표준 AR 생성의 통합은 기존의 다중 모드 생성 프레임 워크와 호환되므로 효율적인 고해상도 이미지의 생성을 가능하게합니다. 실험 결과는 토큰 셔프의 잠재력을 강조하여 AR 모델을 사전 해상도 한계를 넘어 밀어 고 충실도, 고해상도 생성보다 실용적이고 접근 가능하게 만듭니다.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.