|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

Token-Shuffle: mise à l'échelle des modèles autorégressifs à des images haute résolution

Apr 26, 2025 at 12:38 pm

Les modèles autorégressifs (AR) ont fait des progrès significatifs dans la génération de langues et sont de plus en plus explorés pour la synthèse d'image.

Autoregressive (AR) models have achieved remarkable progress in language generation and are increasingly being explored for image synthesis. However, scaling AR models to high-resolution images presents a persistent challenge. Unlike text, which requires relatively few tokens, high-resolution images necessitate thousands of tokens, leading to a quadratic growth in computational cost. As a result, most AR-based multimodal models are constrained to low or medium resolutions, limiting their utility for detailed image generation. While diffusion models have shown promising results at high resolutions, they come with their own limitations, including complex sampling procedures and slower inference. Addressing the token efficiency bottleneck in AR models remains a crucial open problem for enabling scalable and practical high-resolution image synthesis.

Les modèles autorégressifs (AR) ont réalisé des progrès remarquables dans la génération de langues et sont de plus en plus explorés pour la synthèse d'image. Cependant, la mise à l'échelle des modèles AR vers des images haute résolution présente un défi persistant. Contrairement au texte, qui nécessite relativement peu de jetons, les images haute résolution nécessitent des milliers de jetons, conduisant à une croissance quadratique du coût de calcul. En conséquence, la plupart des modèles multimodaux basés sur AR sont limités à des résolutions faibles ou moyennes, limitant leur utilité pour une génération d'images détaillée. Bien que les modèles de diffusion aient montré des résultats prometteurs à des résolutions élevées, ils viennent avec leurs propres limitations, y compris des procédures d'échantillonnage complexes et une inférence plus lente. La lutte contre le goulot d'étranglement de l'efficacité des jetons dans les modèles AR reste un problème ouvert crucial pour permettre une synthèse d'image à haute résolution évolutive et pratique.

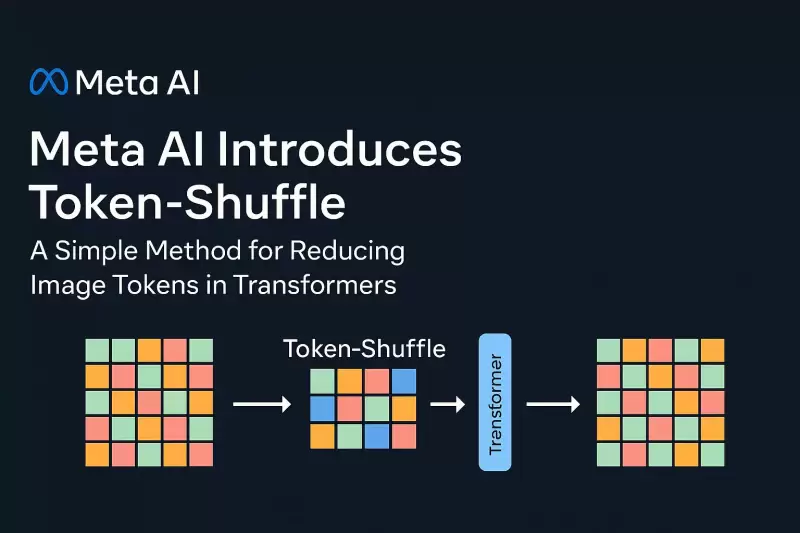

In a new contribution by Meta AI, researchers introduce Token-Shuffle, a method designed to reduce the number of image tokens processed by Transformers without altering the fundamental next-token prediction reach. The key insight underpinning Token-Shuffle is the recognition of dimensional redundancy in visual vocablies used by multimodal large language models (MLLMs). Visual tokens, typically derived from vecor quantization (VQ) models, occupy high-dimensional spaces but carry a lower intrinsic information density compared to text tokens. Token-Shuffle exploits this property by merging spatially local visual tokens along the channel dimension before Transformer processing and subsequently restoring the original spatial structure after inference. This token fusion mechanism allows AR models to handle higher resolutions with significantly reduced computational cost while maintaining visual fidelity.

Dans une nouvelle contribution de Meta IA, les chercheurs introduisent des token-shuffes, une méthode conçue pour réduire le nombre de jetons d'image traités par les transformateurs sans modifier la portée de prédiction fondamentale du prochain. L'informatique clé qui sous-tend les token-shuffes est la reconnaissance de la redondance dimensionnelle dans les vocablies visuelles utilisées par les modèles multimodaux de grande langue (MLLMS). Les jetons visuels, généralement dérivés des modèles de quantification VECOR (VQ), occupent des espaces à haute dimension mais portent une densité d'informations intrinsèques plus faible par rapport aux jetons de texte. Token-Shuffle exploite cette propriété en fusionnant les jetons visuels spatialement locaux le long de la dimension du canal avant le traitement du transformateur et en restaurant par la suite la structure spatiale d'origine après l'inférence. Ce mécanisme de fusion de jeton permet aux modèles AR de gérer des résolutions plus élevées avec un coût de calcul considérablement réduit tout en maintenant la fidélité visuelle.

Token-Shuffle consists of two operations: token-shuffle and token-unshuffle. During input preparation, spatially neighboring tokens are merged using an MLP to form a compressed token that preserves essential local information. For a shuffle window size sss, the number of tokens is reduced by a factor of s2s^2s2, leading to a substantial reduction in Transformer FLOPs. After the Transformer layers, the token-unshuffle operation reconstructs the original spatial arrangement, again assisted by lightweight MLPs.

Token-Shuffle se compose de deux opérations: les token-shuffes et le token-unhuffle. Pendant la préparation des entrées, les jetons spatialement voisins sont fusionnés à l'aide d'un MLP pour former un jeton comprimé qui préserve les informations locales essentielles. Pour un SSS de taille de fenêtre Shuffle, le nombre de jetons est réduit d'un facteur de S2S ^ 2S2, conduisant à une réduction substantielle des flops de transformateur. Après les couches du transformateur, l'opération de token-Unhuffle reconstruit la disposition spatiale d'origine, à nouveau aidée par des MLP légers.

By compressing token sequences during Transformer computation, Token-Shuffle enables the efficient generation of high-resolution images, including those at 2048×2048 resolution. Importantly, this approach does not require modifications to the Transformer architecture itself, nor does it introduce auxiliary loss functions or pretraining of additional encoders.

En compressant les séquences de jetons pendant le calcul du transformateur, les cas de jeton permet la génération efficace d'images à haute résolution, y compris celles à la résolution 2048 × 2048. Surtout, cette approche ne nécessite pas de modifications de l'architecture du transformateur elle-même, ni introduit des fonctions de perte auxiliaires ou de prélèvement des encodeurs supplémentaires.

Moreover, the method integrates a classifier-free guidance (CFG) scheduler specifically adapted for autoregressive generation. Rather than applying a fixed guidance scale across all tokens, the scheduler progressively adjusts guidance strength, minimizing early token artifacts and improving text-image alignment.

De plus, la méthode intègre un planificateur de guidage sans classificateur (CFG) spécifiquement adapté pour la génération autorégressive. Plutôt que d'appliquer une échelle de guidage fixe sur tous les jetons, le planificateur ajuste progressivement la force de guidage, la minimisation des artefacts de jetons précoces et l'amélioration de l'alignement de l'image du texte.

Token-Shuffle was evaluated on two major benchmarks: GenAI-Bench and GenEval. On GenAI-Bench, using a 2.7B parameter LLaMA-based model, Token-Shuffle achieved a VQAScore of 0.77 on “hard” prompts, outperforming other autoregressive models such as LlamaGen by a margin of +0.18 and diffusion models like LDM by +0.15. In the GenEval benchmark, it attained an overall score of 0.62, setting a new baseline for AR models operating in the discrete token regime.

Les token-shuffes ont été évalués sur deux références majeures: Genai-Bench et Geneval. Sur Genai-Bench, en utilisant un modèle basé sur le paramètre 2,7b, les token-shuffes ont obtenu un VQASCore de 0,77 sur des invites «dures», surpassant d'autres modèles autorégressifs tels que Llamagen par une marge de +0,18 et des modèles de diffusion comme LDM par +0,15. Dans la référence Geneval, il a atteint un score global de 0,62, établissant une nouvelle base de référence pour les modèles AR opérant dans le régime de jetons discrets.

Large-scale human evaluation on two benchmarks, GenAI-Bench and GenEval

Évaluation humaine à grande échelle sur deux repères, Genai-Bench et Geneval

Furthermore, Token-Shuffle was subjected to large-scale human evaluation on two benchmarks, GenAI-Bench and GenEval. The results indicated that compared to LlamaGen, Lumina-mGPT, and diffusion baselines, Token-Shuffle showed improved alignment with textual prompts, reduced visual flaws, and higher subjective image quality in most cases. However, minor degradation in logical consistency was observed relative to diffusion models, suggesting avenues for further refinement.

En outre, les token-shuffes ont été soumis à une évaluation humaine à grande échelle sur deux repères, Genai-Bench et Geneval. Les résultats ont indiqué que par rapport aux llamagènes, Lumina-MGPT et les références de diffusion, les token-shuffes ont montré un alignement amélioré avec des invites textuelles, des défauts visuels réduits et une qualité d'image subjective plus élevée dans la plupart des cas. Cependant, une dégradation mineure de la cohérence logique a été observée par rapport aux modèles de diffusion, suggérant des voies pour un raffinement supplémentaire.

In terms of visual quality, Token-Shuffle demonstrated the capability to produce detailed and coherent 1024×1024 and 2048×2048 images. Ablation studies revealed that smaller shuffle window sizes (e.g., 2×2) offered the best trade-off between computational efficiency and output quality. Larger window sizes provided additional speedups but introduced minor losses in fine-grained detail.

En termes de qualité visuelle, les token-shuffes ont démontré la capacité de produire des images détaillées et cohérentes 1024 × 1024 et 2048 × 2048. Des études d'ablation ont révélé que les tailles de fenêtres de mélange plus petites (par exemple, 2 × 2) offraient le meilleur compromis entre l'efficacité de calcul et la qualité de sortie. Des tailles de fenêtre plus grandes ont fourni des accéléreuses supplémentaires, mais ont introduit des pertes mineures dans des détails à grain fin.

All in all, the researchers present a simple yet effective method to address the scalability limitations of autoregressive image generation. By merging spatially local visual tokens during the Transformer computation, their approach reduces the computational complexity without altering the fundamental next-token prediction step. This integration of spatial compression with standard AR generation is compatible with existing multimodal generation frameworks, enabling the efficient generation of high-resolution images. The experimental results highlight the potential of Token-Shuffle to push AR models beyond prior resolution limits, making high-fidelity, high-resolution generation more practical and accessible.

Dans l'ensemble, les chercheurs présentent une méthode simple mais efficace pour répondre aux limites d'évolutivité de la génération d'images autorégressives. En fusionnant les jetons visuels spatialement locaux pendant le calcul du transformateur, leur approche réduit la complexité de calcul sans altérer l'étape de prédiction fondamentale du prochain. Cette intégration de la compression spatiale avec la génération d'AR standard est compatible avec les cadres de génération multimodale existants, permettant la génération efficace d'images à haute résolution. Les résultats expérimentaux mettent en évidence le potentiel des casquettes de jeton pour pousser les modèles AR au-delà des limites de résolution antérieures, ce qui rend la génération haute fidélité et haute résolution plus pratique et plus accessible.

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

-

-

- Des sans-abri au propriétaire: une bague, une bonne action et une vie transformée

- Aug 01, 2025 at 05:47 am

- Explorez l'histoire réconfortante de Billy Ray Harris, un sans-abri dont l'honnêteté a transformé une bague perdue en une opportunité qui change la vie, tout en mettant en lumière la question plus large du sans-abrisme.

-

-

-

- Les applications de Solana ETF augmentent au milieu du soutien institutionnel croissant

- Aug 01, 2025 at 05:24 am

- Les applications de Solana ETF inondent la SEC à mesure que l'intérêt institutionnel monte. Solana sera-t-elle la prochaine crypto à pénétrer dans le monde des investissements grand public?

-

- SEC, crypto et titres: naviguer dans la nouvelle frontière

- Aug 01, 2025 at 04:04 am

- Project Crypto: SEC Modernise les règles de titres pour les actifs numériques, en abordant l'intégration de Crypto dans la finance. Cette initiative audacieuse propulsera-t-elle les États-Unis au leadership cryptographique?

-

- Spartiates, paris sportifs et la première place: une nouvelle ère de jeu de cryptographie

- Aug 01, 2025 at 04:00 am

- Spartans.com secoue la scène des paris sportifs avec des fonctionnalités axées sur la crypto, des paiements rapides et des jeux de crash passionnants, remettant en question les plates-formes traditionnelles pour la première place.

-