|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

Petit modèle, récursif, apprentissage automatique : moins c'est plus ?

Oct 20, 2025 at 02:31 am

Explorer la tendance des modèles minuscules et récursifs dans l'apprentissage automatique, en se concentrant sur TRM et ses implications en termes d'efficacité et de performances.

The world of machine learning is constantly evolving, with researchers always seeking ways to improve performance and efficiency. Lately, there's been buzz around 'Tiny model, recursive, machine learning' approaches. Let's dive into what's shaking in this field.

Le monde de l’apprentissage automatique est en constante évolution, les chercheurs cherchant toujours des moyens d’améliorer les performances et l’efficacité. Dernièrement, il y a eu un buzz autour des approches de « modèle minuscule, récursif, d'apprentissage automatique ». Plongeons dans ce qui bouge dans ce domaine.

The Rise of Tiny Recursive Models

L'essor des petits modèles récursifs

The recent work on TRM (Tiny Recursive Model) is questioning the necessity of complexity. TRM contains 5M-19M parameters, versus 27M in HRM. These models represent a fascinating shift towards simplicity and efficiency, challenging the conventional wisdom that bigger is always better.

Les travaux récents sur le TRM (Tiny Recursive Model) questionnent la nécessité de la complexité. TRM contient 5 M à 19 M de paramètres, contre 27 M dans HRM. Ces modèles représentent un changement fascinant vers la simplicité et l’efficacité, remettant en question l’idée reçue selon laquelle plus grand est toujours mieux.

TRM: A Closer Look

TRM : un examen plus approfondi

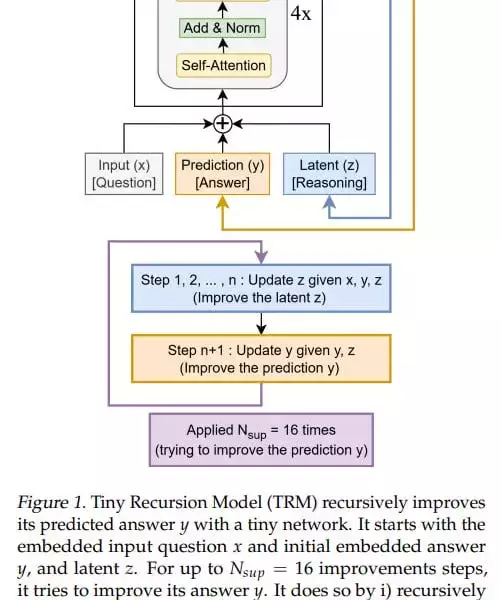

TRM simplifies the recursive process, designed with one small network, which is essentially a standard transformer block: [self-attention, norm, MLP, norm]. The model is designed so that there’s one small network, which is essentially a standard transformer block: [self-attention, norm, MLP, norm]. In the original idea, there were 4 such blocks (but after experiments they came to 2).

TRM simplifie le processus récursif, conçu avec un petit réseau, qui est essentiellement un bloc de transformateur standard : [auto-attention, norme, MLP, norme]. Le modèle est conçu de telle sorte qu'il existe un petit réseau, qui est essentiellement un bloc de transformateur standard : [auto-attention, norme, MLP, norme]. Dans l'idée originale, il y avait 4 blocs de ce type (mais après expériences, ils sont arrivés à 2).

At the input, it has three elements: input (x), latent (z), and prediction (y); they’re all summed into one value. The basic iteration, analogous to the L module in HRM, generates a latent value (z, also denoted in the recursion formula as z_L) at the layer output, and the updated z goes back to the module input, where it now adds to input (x) not as zero. The output-prediction (y, also denoted in the formula as z_H) is also added, but since it hasn’t been updated, it doesn’t change anything.

En entrée, il comporte trois éléments : entrée (x), latent (z) et prédiction (y) ; ils sont tous résumés en une seule valeur. L'itération de base, analogue au module L dans HRM, génère une valeur latente (z, également désignée dans la formule de récursion par z_L) à la sortie de la couche, et le z mis à jour retourne à l'entrée du module, où il s'ajoute désormais à l'entrée (x) non pas comme zéro. La prédiction de sortie (y, également notée z_H dans la formule) est également ajoutée, mais comme elle n'a pas été mise à jour, cela ne change rien.

Key Insights and Performance

Informations clés et performances

TRM achieves higher numbers than HRM: 74.7%/87.4% (attention version/MLP version) versus 55% for Sudoku, 85.3% (attention version, MLP version gives 0) versus 74.5% for Maze, 44.6%/29.6% (attn/MLP) versus 40.3% for ARC-AGI-1 and 7.8%/2.4% (attn/MLP) versus 5.0% for ARC-AGI-2. The experiments don’t look very expensive; runtime from <24 hours to about three days maximum on 4*H100 according to the repo.

TRM obtient des chiffres plus élevés que HRM : 74,7%/87,4% (version attention/version MLP) contre 55% pour Sudoku, 85,3% (version attention, version MLP donne 0) contre 74,5% pour Maze, 44,6%/29,6% (attn/MLP) contre 40,3% pour ARC-AGI-1 et 7,8%/2,4% (attn/MLP) contre 5,0 % pour ARC-AGI-2. Les expériences ne semblent pas très coûteuses ; durée d'exécution de <24 heures à environ trois jours maximum sur 4*H100 selon le repo.

My Two Cents

Mes deux cents

While the theoretical underpinnings of why these recursions work so well might not be fully understood yet, the empirical results are hard to ignore. TRM's architectural inventiveness, as opposed to eternal model scaling, is a breath of fresh air. It would be interesting how it would be with dataset scaling.

Même si les fondements théoriques expliquant pourquoi ces récursions fonctionnent si bien ne sont peut-être pas encore entièrement compris, les résultats empiriques sont difficiles à ignorer. L'inventivité architecturale de TRM, par opposition à la mise à l'échelle éternelle des modèles, est une bouffée d'air frais. Il serait intéressant de savoir comment cela se passerait avec la mise à l'échelle des ensembles de données.

Looking Ahead

Regarder vers l'avenir

The journey of 'Tiny model, recursive, machine learning' is just beginning. There's a lot more to explore. So, let's keep an eye on these tiny titans and see where they take us next. Good recursions to everyone!

Le voyage du « petit modèle, récursif, apprentissage automatique » ne fait que commencer. Il y a beaucoup plus à explorer. Alors gardons un œil sur ces petits titans et voyons où ils nous mèneront ensuite. Bonnes récursions à tous !

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

- Le problème du stationnement à Rotorua : les pièces de monnaie seront-elles encaissées dans la ville de Sulphur ?

- Feb 10, 2026 at 06:05 am

- Le système de stationnement de Rotorua fait face à une refonte majeure, avec des paiements en pièces sur le billot. Le conseil sollicite l'avis du public sur l'évolution vers des solutions modernes et efficaces.

-

- PEPE Price navigue dans des eaux dangereuses : un soutien clé assiégé au milieu d'une pression incessante des ours

- Feb 10, 2026 at 05:37 am

- Le prix du PEPE est confronté à une intense pression baissière, testant des niveaux de support cruciaux. Les données techniques suggèrent une consolidation avec un potentiel de rebond, mais des risques à la baisse persistent pour le jeton mème.

-

- Binance, Ripple (XRP) et Altcoins : un bouleversement du marché à l'horizon

- Feb 10, 2026 at 05:33 am

- Binance ajuste ses cotations, XRP fait face à la volatilité dans un contexte de croissance institutionnelle et l'activité des développeurs d'altcoin signale les tendances futures. Une mise à jour du marché.

-

- Les étapes changeantes de l'honneur, le Kennedy Center et la philanthropie moderne

- Feb 10, 2026 at 05:33 am

- Du réalignement politique du Kennedy Center à la montée des dons cryptographiques, les institutions culturelles américaines naviguent dans une nouvelle ère de reconnaissance et de soutien financier.

-

- Vitalik Buterin défend la confidentialité DeFi : une nouvelle ère pour la crypto ?

- Feb 10, 2026 at 05:28 am

- Le co-fondateur d'Ethereum, Vitalik Buterin, fait pression pour une DeFi centrée sur la confidentialité, signalant un changement potentiel dans l'adoption de la cryptographie. Explorez les dernières tendances et idées.

-

-

- Le siècle d'un capitaine : la masterclass de Koby Brann enflamme l'esprit durable du cricket

- Feb 10, 2026 at 05:19 am

- Au milieu d'une confrontation locale au cricket, le siècle stellaire du capitaine de l'OMK, Koby Brann, a captivé les fans, reflétant la volonté mondiale du sport d'inspirer les nouvelles générations et de favoriser les talents, de la base aux ligues professionnelles.

-

- La course folle de Wall Street : Bitcoin, QQQ et la nouvelle ère de volatilité

- Feb 10, 2026 at 04:53 am

- Les récentes turbulences du marché voient QQQ chuter à mesure que Bitcoin évolue, suscitant des débats sur les perturbations technologiques, l'impact systémique de la cryptographie et l'évolution des stratégies.

-

- Le grand refroidissement SHIB : la manœuvre de stockage frigorifique d'OKX déclenche la récupération tandis que celle de Binance passe inaperçue

- Feb 10, 2026 at 04:42 am

- Le récent transfert du Shiba Inu par OKX vers un entrepôt frigorifique a coïncidé avec une hausse notable des prix, suscitant un débat sur la dynamique du marché, alors qu'une décision similaire de Binance n'a pas eu un tel impact.

![Code d'invitation EveryPoint Every Point [ukPj5KNl] Activité de marche Poi ! Gagnez de l'argent de poche en comptant les pas, podomètre [Gagnez en marchant] Code d'invitation EveryPoint Every Point [ukPj5KNl] Activité de marche Poi ! Gagnez de l'argent de poche en comptant les pas, podomètre [Gagnez en marchant]](/uploads/2026/02/10/cryptocurrencies-news/videos/origin_698a7eb202ea2_image_500_375.webp)