|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

Winziges Modell, rekursiv, maschinelles Lernen: Weniger ist mehr?

Oct 20, 2025 at 02:31 am

Erkundung des Trends zu winzigen, rekursiven Modellen beim maschinellen Lernen mit Schwerpunkt auf TRM und seinen Auswirkungen auf Effizienz und Leistung.

The world of machine learning is constantly evolving, with researchers always seeking ways to improve performance and efficiency. Lately, there's been buzz around 'Tiny model, recursive, machine learning' approaches. Let's dive into what's shaking in this field.

Die Welt des maschinellen Lernens entwickelt sich ständig weiter und Forscher suchen stets nach Möglichkeiten, Leistung und Effizienz zu verbessern. In letzter Zeit wird viel über Ansätze des „winzigen Modells, des rekursiven maschinellen Lernens“ gesprochen. Werfen wir einen Blick auf die Ereignisse in diesem Bereich.

The Rise of Tiny Recursive Models

Der Aufstieg winziger rekursiver Modelle

The recent work on TRM (Tiny Recursive Model) is questioning the necessity of complexity. TRM contains 5M-19M parameters, versus 27M in HRM. These models represent a fascinating shift towards simplicity and efficiency, challenging the conventional wisdom that bigger is always better.

Die jüngsten Arbeiten zu TRM (Tiny Recursive Model) stellen die Notwendigkeit von Komplexität in Frage. TRM enthält 5 bis 19 Millionen Parameter, im Vergleich zu 27 Millionen im HRM. Diese Modelle stellen einen faszinierenden Wandel hin zu Einfachheit und Effizienz dar und stellen die gängige Meinung in Frage, dass größer immer besser ist.

TRM: A Closer Look

TRM: Ein genauerer Blick

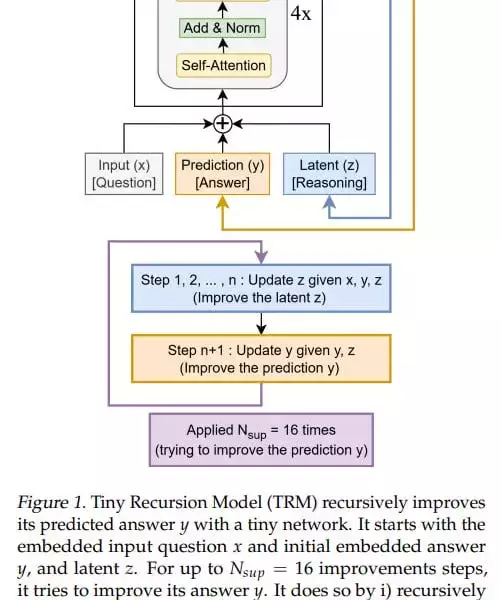

TRM simplifies the recursive process, designed with one small network, which is essentially a standard transformer block: [self-attention, norm, MLP, norm]. The model is designed so that there’s one small network, which is essentially a standard transformer block: [self-attention, norm, MLP, norm]. In the original idea, there were 4 such blocks (but after experiments they came to 2).

TRM vereinfacht den rekursiven Prozess, der mit einem kleinen Netzwerk entworfen wurde, das im Wesentlichen ein Standardtransformatorblock ist: [Selbstaufmerksamkeit, Norm, MLP, Norm]. Das Modell ist so konzipiert, dass es ein kleines Netzwerk gibt, das im Wesentlichen ein Standardtransformatorblock ist: [Selbstaufmerksamkeit, Norm, MLP, Norm]. In der ursprünglichen Idee gab es 4 solcher Blöcke (nach Experimenten kamen sie jedoch auf 2).

At the input, it has three elements: input (x), latent (z), and prediction (y); they’re all summed into one value. The basic iteration, analogous to the L module in HRM, generates a latent value (z, also denoted in the recursion formula as z_L) at the layer output, and the updated z goes back to the module input, where it now adds to input (x) not as zero. The output-prediction (y, also denoted in the formula as z_H) is also added, but since it hasn’t been updated, it doesn’t change anything.

Am Eingang gibt es drei Elemente: Eingabe (x), latent (z) und Vorhersage (y); Sie werden alle zu einem Wert zusammengefasst. Die grundlegende Iteration, analog zum L-Modul in HRM, generiert einen latenten Wert (z, in der Rekursionsformel auch als z_L bezeichnet) am Layer-Ausgang, und der aktualisierte z geht zurück zum Moduleingang, wo er nun zum Eingang (x) hinzugefügt wird, nicht als Null. Die Ausgabevorhersage (y, in der Formel auch als z_H bezeichnet) wird ebenfalls hinzugefügt, aber da sie nicht aktualisiert wurde, ändert sie nichts.

Key Insights and Performance

Wichtige Erkenntnisse und Leistung

TRM achieves higher numbers than HRM: 74.7%/87.4% (attention version/MLP version) versus 55% for Sudoku, 85.3% (attention version, MLP version gives 0) versus 74.5% for Maze, 44.6%/29.6% (attn/MLP) versus 40.3% for ARC-AGI-1 and 7.8%/2.4% (attn/MLP) versus 5.0% for ARC-AGI-2. The experiments don’t look very expensive; runtime from <24 hours to about three days maximum on 4*H100 according to the repo.

TRM erreicht höhere Zahlen als HRM: 74,7 %/87,4 % (Aufmerksamkeitsversion/MLP-Version) gegenüber 55 % für Sudoku, 85,3 % (Aufmerksamkeitsversion, MLP-Version gibt 0) gegenüber 74,5 % für Labyrinth, 44,6 %/29,6 % (Aufmerksamkeitsversion/MLP) gegenüber 40,3 % für ARC-AGI-1 und 7,8 %/2,4 % (attn/MLP) gegenüber 5,0 % für ARC-AGI-2. Die Experimente sehen nicht sehr teuer aus; Laufzeit von <24 Stunden bis maximal etwa drei Tage auf 4*H100 laut Repo.

My Two Cents

Meine zwei Cent

While the theoretical underpinnings of why these recursions work so well might not be fully understood yet, the empirical results are hard to ignore. TRM's architectural inventiveness, as opposed to eternal model scaling, is a breath of fresh air. It would be interesting how it would be with dataset scaling.

Während die theoretischen Grundlagen, warum diese Rekursionen so gut funktionieren, möglicherweise noch nicht vollständig verstanden sind, sind die empirischen Ergebnisse schwer zu ignorieren. Der architektonische Erfindungsreichtum von TRM ist im Gegensatz zur ewigen Modellskalierung ein Hauch frischer Luft. Es wäre interessant, wie es mit der Datensatzskalierung wäre.

Looking Ahead

Blick nach vorn

The journey of 'Tiny model, recursive, machine learning' is just beginning. There's a lot more to explore. So, let's keep an eye on these tiny titans and see where they take us next. Good recursions to everyone!

Die Reise des „winzigen Modells, rekursives, maschinelles Lernen“ hat gerade erst begonnen. Es gibt noch viel mehr zu entdecken. Behalten wir also diese winzigen Titanen im Auge und schauen wir, wohin sie uns als nächstes führen. Gute Rekursionen an alle!

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

-

- Der kritische Zeitpunkt von XRP entspricht der Auktionsprognose von ZKP Crypto: KI-Datenschutz definiert Knappheit neu

- Feb 09, 2026 at 02:00 am

- Anfang 2026 kämpft XRP mit einem Zweijahrestief, während der innovative KI-Datenschutz und die knappheitsgesteuerten Auktionsprognosen der ZKP-Kryptowährung eine neue Ära voller Chancen versprechen. Es ist eine Geschichte von Marktveränderungen.

-

- Polly Cooper, Oneida-Frau, auf neuer 1-Dollar-Münze verewigt: Anerkennung einer entscheidenden Figur des Unabhängigkeitskrieges

- Feb 09, 2026 at 02:00 am

- Auf der Sacagawea-1-Dollar-Münze 2026 ist die Oneida-Frau Polly Cooper abgebildet, die ihre entscheidende Hilfe im Unabhängigkeitskrieg würdigt. Diese Anerkennung löst einen Dialog über die Geschichte der amerikanischen Ureinwohner aus.

-

- Super Bowl Coin Toss-Wettmärkte: Ein Blick auf die Chancen und Trends

- Feb 09, 2026 at 01:30 am

- Der Super Bowl-Münzwurf, ein scheinbar einfaches 50/50-Angebot, hat sich zu einem bedeutenden Wettmarkt entwickelt. Dieser Bericht befasst sich mit den Quoten, historischen Trends und Wettoptionen, die für diese beliebte Super Bowl-Requisite verfügbar sind.

-

- DraftKings-Angebote: Erhalten Sie Bonuswetten im Wert von 300 $, kein Promo-Code erforderlich!

- Feb 09, 2026 at 01:15 am

- DraftKings elektrisiert die Wettszene mit einem unwiderstehlichen Angebot: Neue Benutzer können bei einem Gewinneinsatz von 5 $ Bonuswetten im Wert von 300 $ erzielen, was große Spiele noch größer macht.

-

- Der Aktienmarkt sieht eine Sektorrotation, da Nvidia die KI vorantreibt und Bitcoin die Volatilität bewältigt

- Feb 09, 2026 at 01:03 am

- Die Analyse der jüngsten Markttrends zeigt einen dynamischen Wandel am Aktienmarkt, wobei Nvidia an der Spitze der KI-Innovation steht, während Bitcoin erhebliche Preisschwankungen erfährt.

-

-

- Jenseits des Hype: ZKP Crypto und LiquidChain definieren die nächste Welle der Vorverkaufs-Crypto

- Feb 09, 2026 at 01:00 am

- Der Blick auf den Kryptomarkt ändert sich. Smart Money sieht jetzt Vorverkaufsmöglichkeiten, wobei ZKP Crypto und LiquidChain Innovationen im Bereich Datenschutz-KI und kettenübergreifende Liquidität anführen. Es ist ein grundlegender Neustart.

-

![Ist das eine ECHTE Umkehrung oder ein Fake-Out? Ich würde mich noch nicht aufregen ... [20-minütiger Notfallstream] Ist das eine ECHTE Umkehrung oder ein Fake-Out? Ich würde mich noch nicht aufregen ... [20-minütiger Notfallstream]](/uploads/2026/02/08/cryptocurrencies-news/videos/origin_698897450a654_image_500_375.webp)

![Mesocosmos (von Biskotos) [Alle Münzen] | Geometry Dash Mesocosmos (von Biskotos) [Alle Münzen] | Geometry Dash](/uploads/2026/02/08/cryptocurrencies-news/videos/origin_69889be2eac64_image_500_375.webp)