|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

大規模な言語モデル(LLM)は、人工知能の分野に革命をもたらし、自然言語の理解と生成において顕著な能力を示しています。相互接続された人工ニューロンの層で構成されるこれらのモデルは、隠された表現として知られる数字のベクトルを介して通信します。ただし、これらの隠された表現内でエンコードされた意味を解読することは、重要な課題でした。機械学習の解釈の分野は、このギャップを埋めることを目指しています。また、Googleの研究者がLLMが「考えている」ことを理解する方法を思いついた「パッチスコープ」。

Large Language Models (LLMs) have revolutionized the field of artificial intelligence, demonstrating remarkable capabilities in natural language understanding and generation. These models, comprised of layers of interconnected artificial neurons, communicate through vectors of numbers known as hidden representations. However, deciphering the meaning encoded within these hidden representations has been a significant challenge. The field of machine learning interpretability seeks to bridge this gap, and "Patchscopes" that Google researchers came up with a method to understand what LLM “thinks”.

大規模な言語モデル(LLM)は、人工知能の分野に革命をもたらし、自然言語の理解と生成において顕著な能力を示しています。相互接続された人工ニューロンの層で構成されるこれらのモデルは、隠された表現として知られる数字のベクトルを介して通信します。ただし、これらの隠された表現内でエンコードされた意味を解読することは、重要な課題でした。機械学習の解釈の分野は、このギャップを埋めることを目指しています。また、Googleの研究者がLLMが「考えている」ことを理解する方法を思いついた「パッチスコープ」。

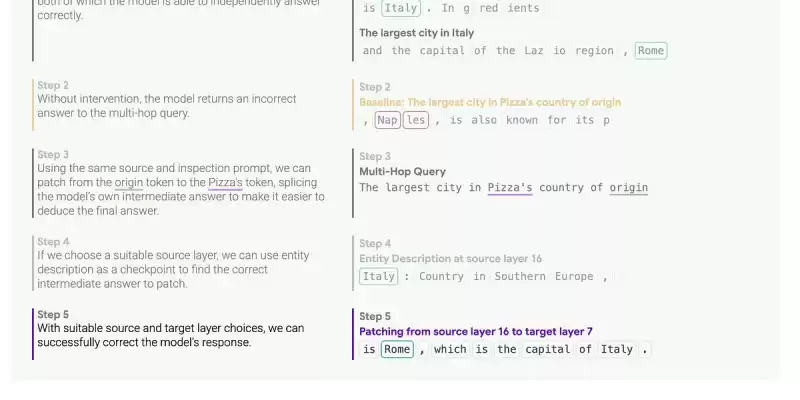

Patchscopes is a novel interpretability method that enables researchers to perform "surgery" on the neurons of an LLM. This involves cutting out and replacing hidden representations between different prompts and layers, allowing for a detailed inspection of the information contained within. The core concept is the "inspection prompt," which acts as a lens into the LLM's mind, facilitating the extraction of human-interpretable meaning. The framework leverages the inherent ability of LLMs to translate their own hidden representations into understandable text.

PatchScopesは、研究者がLLMのニューロンで「手術」を実行できるようにする新しい解釈可能性方法です。これには、異なるプロンプトとレイヤー間の隠された表現を切り取り、交換するため、内部に含まれる情報の詳細な検査が可能になります。コアコンセプトは「検査プロンプト」であり、LLMの心にレンズとして機能し、人間の解釈可能な意味の抽出を促進します。フレームワークは、LLMの固有の能力を活用して、独自の隠された表現を理解できるテキストに変換します。

Understanding the Transformer Architecture: A Foundation for Patchscopes

トランスアーキテクチャの理解:パッチスコープの基礎

Patchscopes builds upon a deep understanding of LLMs and the transformer architecture, which forms the backbone of many modern language models. Transformer models process text by first tokenizing the input, breaking it down into smaller units (words or sub-words). Each token is then embedded into a high-dimensional vector space, creating an initial hidden representation.

PatchScopesは、多くの現代言語モデルのバックボーンを形成するLLMSとトランスアーキテクチャの深い理解に基づいています。トランスモデルは、最初に入力をトークン化してテキストを処理し、小さなユニット(単語またはサブワード)に分割します。各トークンは、高次元ベクトル空間に埋め込まれ、初期の隠された表現を作成します。

The transformer architecture consists of multiple layers of transformer blocks. Each layer refines the hidden representation based on the output of the preceding layer and the relationships between tokens in the input sequence. This process continues through the final layer, where the hidden representation is used to generate the output text. Decoder-only models, which are the focus of Patchscopes, only consider preceding tokens when generating the next token, making them particularly well-suited for language generation tasks.

トランスアーキテクチャは、トランスブロックの複数の層で構成されています。各レイヤーは、前のレイヤーの出力と入力シーケンスのトークン間の関係に基づいて、隠された表現を改良します。このプロセスは、隠された表現を使用して出力テキストを生成する最終層を介して続きます。パッチスコープの焦点であるデコーダーのみのモデルは、次のトークンを生成するときに前のトークンのみを考慮して、言語生成タスクに特に適しています。

The Patchscopes framework operates on a simple yet powerful premise: LLMs possess the inherent ability to translate their own hidden representations into human-understandable text. By patching hidden representations between different locations during inference, researchers can inspect the information within a hidden representation, understand LLM behavior, and even augment the model's performance.

PatchScopesフレームワークは、シンプルでありながら強力な前提で動作します。LLMSは、独自の隠された表現を人間に理解しやすいテキストに変換する固有の能力を持っています。推論中に異なる場所間で隠された表現にパッチを適用することにより、研究者は隠された表現内の情報を検査し、LLMの動作を理解し、モデルのパフォーマンスを強化することさえできます。

The process involves several key steps:

このプロセスには、いくつかの重要なステップが含まれます。

Source Prompt: A source prompt is fed into the LLM, generating hidden representations at each layer. This prompt serves as the context from which information will be extracted.

ソースプロンプト:ソースプロンプトがLLMに供給され、各レイヤーで隠された表現が生成されます。このプロンプトは、情報が抽出されるコンテキストとして機能します。

Inspection Prompt: An inspection prompt is designed to elicit a specific type of information from the LLM. This prompt typically includes a placeholder token where the hidden representation from the source prompt will be inserted.

検査プロンプト:検査プロンプトは、LLMから特定の種類の情報を引き出すように設計されています。このプロンプトには、通常、ソースプロンプトからの隠された表現が挿入されるプレースホルダートークンが含まれます。

Patching: The hidden representation from a specific layer and token position in the source prompt is "patched" into the placeholder token in the inspection prompt. This effectively replaces the LLM's internal representation with the extracted information.

パッチ:ソースプロンプトの特定のレイヤーとトークンの位置からの隠された表現は、検査プロンプトのプレースホルダートークンに「パッチされている」。これにより、LLMの内部表現を抽出された情報に効果的に置き換えます。

Generation: The LLM continues decoding from the patched inspection prompt, generating text based on the combined information from the source and inspection prompts.

生成:LLMは、パッチされた検査プロンプトからデコードを続け、ソースと検査プロンプトからの組み合わせ情報に基づいてテキストを生成します。

Analysis: The generated text is analyzed to understand the information encoded in the hidden representation. This can involve evaluating the accuracy of factual information, identifying the concepts captured by the representation, or assessing the model's reasoning process.

分析:生成されたテキストを分析して、隠された表現でエンコードされた情報を理解します。これには、事実情報の正確性を評価したり、表現によってキャプチャされた概念を特定したり、モデルの推論プロセスを評価したりすることが含まれます。

Case Study 1: Entity Resolution

ケーススタディ1:エンティティの決議

The first case study explores how LLMs resolve entities (people, places, movies, etc.) across different layers of the model. The goal is to understand at what point the model associates a token with its correct meaning. For example, how does the model determine that "Diana" refers to "Princess Diana" rather than the generic name?

最初のケーススタディでは、LLMがモデルのさまざまなレイヤーにわたってエンティティ(人、場所、映画など)をどのように解決するかを調査します。目標は、モデルがトークンを正しい意味に関連付ける時点でどの時点で理解するかを理解することです。たとえば、モデルは、「ダイアナ」が一般名ではなく「ダイアナ王女」を指すことをどのように判断しますか?

To investigate this, a source prompt containing the entity name is fed into the LLM. The hidden representation of the entity token is extracted at each layer and patched into an inspection prompt designed to elicit a description of the entity. By analyzing the generated descriptions, researchers can determine when the model has successfully resolved the entity.

これを調査するために、エンティティ名を含むソースプロンプトがLLMに供給されます。エンティティトークンの隠された表現は、各レイヤーで抽出され、エンティティの説明を引き出すように設計された検査プロンプトにパッチされます。生成された説明を分析することにより、研究者はモデルがエンティティを正常に解決した時期を決定できます。

The results of this case study suggest that entity resolution typically occurs in the early layers of the model (before layer 20). This aligns with theories about layer function, which posit that early layers are responsible for establishing context from the prompt. The study also reveals that tokenization (how the input text is broken down into tokens) has a significant impact on how the model navigates its embedding space.

このケーススタディの結果は、エンティティの解決が通常、モデルの初期層(レイヤー20の前)で発生することを示唆しています。これは、層関数に関する理論と一致し、初期層がプロンプトからコンテキストを確立する責任があると仮定します。また、この研究では、トークン化(入力テキストがトークンに分解される方法)が、モデルが埋め込みスペースをナビゲートする方法に大きな影響を与えることを明らかにしています。

Case Study 2: Attribute Extraction

ケーススタディ2:属性抽出

The second case study focuses on evaluating how accurately the model's hidden representation captures well-known concepts and their attributes. For example, can the model identify that the largest city in Spain is Madrid?

2番目のケーススタディでは、モデルの隠された表現がよく知られている概念とその属性をどの程度正確にキャプチャするかを評価することに焦点を当てています。たとえば、モデルはスペイン最大の都市がマドリードであることを特定できますか?

To extract an attribute, a source prompt containing the subject (e.g., "Spain") is fed into the LLM. The hidden representation of the subject token is extracted and patched into an inspection prompt designed to elicit the specific attribute (e.g., "The largest city is x"). By analyzing the generated text, researchers can determine whether the model correctly identifies the attribute.

属性を抽出するために、主題(「スペイン」など)を含むソースプロンプトがLLMに供給されます。対象トークンの隠された表現は抽出され、特定の属性を引き出すように設計された検査プロンプトにパッチされます(例:「最大の都市はX」)。生成されたテキストを分析することにより、研究者はモデルが属性を正しく識別するかどうかを判断できます。

This case study compares Patchscopes to a technique called "probing," which involves training a classifier to predict an attribute from a hidden representation. Unlike probing, Patchscopes does not

このケーススタディでは、パッチスコープを「プロービング」と呼ばれる手法と比較します。これには、隠された表現から属性を予測するために分類器をトレーニングすることが含まれます。プロービングとは異なり、パッチスコープはそうではありません

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。