|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

Apprentissage du renforcement avec rétroaction humaine: expliquée simplement pour le profane

Jun 24, 2025 at 07:31 am

Démystifier l'apprentissage du renforcement avec la rétroaction humaine (RLHF): Découvrez comment cette technique alimente Chatgpt et d'autres modèles de langage avancé, tous expliqués en termes simples.

Reinforcement Learning with Human Feedback: Explained Simply for the Layman

Apprentissage du renforcement avec rétroaction humaine: expliquée simplement pour le profane

ChatGPT's arrival in 2022 revolutionized our perception of AI. Its impressive capabilities spurred the creation of other powerful Large Language Models (LLMs). A key innovation behind ChatGPT's success is Reinforcement Learning from Human Feedback (RLHF). This article provides a simplified explanation of RLHF, avoiding complex reinforcement learning jargon.

L'arrivée de Chatgpt en 2022 a révolutionné notre perception de l'IA. Ses capacités impressionnantes ont stimulé la création d'autres modèles de grande langue puissants (LLM). Une innovation clé derrière le succès de Chatgpt est le renforcement de l'apprentissage de la rétroaction humaine (RLHF). Cet article fournit une explication simplifiée du RLHF, en évitant le jargon d'apprentissage en renforcement complexe.

NLP Development Before ChatGPT: The Bottleneck of Human Annotation

Développement NLP avant Chatgpt: Le goulot d'étranglement de l'annotation humaine

Traditionally, LLM development involved two main stages:

Traditionnellement, le développement de LLM impliquait deux étapes principales:

- Pre-training: Language modeling where the model predicts hidden words, learning language structure and meaning.

- Fine-tuning: Adapting the model for specific tasks like summarization or question answering, often requiring human-labeled data.

The fine-tuning stage faces a significant hurdle: the need for extensive human annotation. For example, creating a question-answering dataset requires humans to provide accurate answers for millions or even billions of questions. This process is time-consuming and doesn't scale well.

Le stade de réglage fin fait face à un obstacle significatif: la nécessité d'une annotation humaine étendue. Par exemple, la création d'un ensemble de données de réponses aux questions oblige les humains à fournir des réponses précises à des millions, voire à des milliards de questions. Ce processus prend du temps et ne s'allonge pas bien.

RLHF: A Smarter Approach to Training LLMs

RLHF: une approche plus intelligente de la formation LLMS

RLHF addresses this limitation by leveraging a clever approach. Instead of asking humans to provide direct answers, it asks them to choose the better answer from a pair of options. This simpler task allows for continuous improvement of models like ChatGPT.

RLHF aborde cette limitation en tirant parti d'une approche intelligente. Au lieu de demander aux humains de fournir des réponses directes, il leur demande de choisir la meilleure réponse parmi une paire d'options. Cette tâche plus simple permet une amélioration continue de modèles comme Chatgpt.

Response Generation: Creating Options for Human Feedback

Génération de réponse: création d'options pour les commentaires humains

LLMs generate responses by predicting the probability of the next word in a sequence. Techniques like nucleus sampling introduce randomness, producing diverse text sequences. RLHF uses these techniques to generate pairs of responses for human evaluation.

Les LLMS génèrent des réponses en prédisant la probabilité du mot suivant dans une séquence. Des techniques telles que l'échantillonnage du noyau introduisent le caractère aléatoire, produisant diverses séquences de texte. RLHF utilise ces techniques pour générer des paires de réponses pour l'évaluation humaine.

Reward Model: Quantifying the Quality of Responses

Modèle de récompense: quantifier la qualité des réponses

The human-labeled data is used to train a "reward model." This model learns to estimate how good or bad a given answer is for an initial prompt, assigning positive values to good responses and negative values to bad ones. The reward model shares the same architecture as the original LLM, but outputs a numerical score instead of text.

Les données marquées par l'homme sont utilisées pour former un «modèle de récompense». Ce modèle apprend à estimer à quel point une réponse donnée est bonne ou mauvaise pour une invite initiale, attribuant des valeurs positives à de bonnes réponses et des valeurs négatives à de mauvaises. Le modèle de récompense partage la même architecture que le LLM d'origine, mais offre un score numérique au lieu du texte.

Training the Original LLM with the Reward Model

Formation du LLM original avec le modèle de récompense

The trained reward model then guides the training of the original LLM. The LLM generates responses, which are evaluated by the reward model. These numerical estimates are used as feedback to update the LLM's weights, refining its ability to generate high-quality responses. This process often utilizes a reinforcement learning algorithm like Proximal Policy Optimization (PPO), which, in simplified terms, can be thought of as similar to backpropagation.

Le modèle de récompense formé guide ensuite la formation du LLM d'origine. Le LLM génère des réponses, qui sont évaluées par le modèle de récompense. Ces estimations numériques sont utilisées comme rétroaction pour mettre à jour les poids de la LLM, affinant sa capacité à générer des réponses de haute qualité. Ce processus utilise souvent un algorithme d'apprentissage de renforcement comme l'optimisation de la politique proximale (PPO), qui, en termes simplifiés, peut être considérée comme similaire à la rétro-compagation.

Inference and Continuous Improvement

Inférence et amélioration continue

During inference (when you're using the model), only the original trained model is used. However, the model can continuously improve in the background by collecting user prompts and asking users to rate which of two responses is better, feeding this back into the reward model and retraining the LLM.

Pendant l'inférence (lorsque vous utilisez le modèle), seul le modèle formé d'origine est utilisé. Cependant, le modèle peut s'améliorer en continu en arrière-plan en collectant des invites d'utilisateurs et en demandant aux utilisateurs de noter lequel des deux réponses est meilleur, de renforcer ce modèle de récompense et de recycler le LLM.

Why This Matters

Pourquoi cela compte

RLHF's beauty lies in its efficiency and scalability. By simplifying the annotation task for humans, it enables the training of powerful LLMs like ChatGPT, Claude, Gemini, and Mistral. It's a game-changer because it allows us to overcome the limitations of traditional fine-tuning methods that rely on extensive, manually labeled datasets. Imagine trying to teach a puppy a trick. Instead of perfectly sculpting its every move, you simply reward it when it gets closer to the desired action. That's the essence of RLHF – guiding the AI with simple feedback.

La beauté de RLHF réside dans son efficacité et son évolutivité. En simplifiant la tâche d'annotation pour les humains, il permet la formation de LLM puissants comme Chatgpt, Claude, Gemini et Mistral. Il change la donne car il nous permet de surmonter les limites des méthodes de réglage fin traditionnelles qui reposent sur des ensembles de données étiquetés manuels et manuellement. Imaginez essayer d'enseigner à un chiot une astuce. Au lieu de sculpter parfaitement chaque mouvement, vous le récompensez simplement lorsqu'il se rapproche de l'action souhaitée. C'est l'essence de RLHF - guider l'IA avec une rétroaction simple.

The Future is Feedback

L'avenir est une rétroaction

RLHF is a really elegant blend of LLMs with a reward model that allows us to greatly simplify the annotation task performed by humans. Who knew that the secret to smarter AI was simply asking for a little human help? Now, if only we could get our algorithms to do the dishes...

RLHF est un mélange vraiment élégant de LLMS avec un modèle de récompense qui nous permet de simplifier considérablement la tâche d'annotation effectuée par les humains. Qui savait que le secret de l'IA plus intelligent demandait simplement un peu d'aide humaine? Maintenant, si seulement nous pouvions amener nos algorithmes à faire la vaisselle ...

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

-

- Bitcoin Holdings Strategy: monter la vague $ BTC comme un Wall Street Pro

- Jun 24, 2025 at 06:25 pm

- Plongez dans le monde des stratégies Bitcoin Holdings, inspirées par les mouvements audacieux de Microstrategy et les prédictions du ciel de Saylor. Bitcoin est-il la nouvelle norme du Trésor d'entreprise?

-

-

- MasterCard, USDG Stablecoin et Fiserv: révolutionner les paiements ou juste une autre mode?

- Jun 24, 2025 at 06:45 pm

- Mastercard plonge plus profondément dans la crypto avec l'USDG, le Pyusd de Paypal et la fiusd de Fiserv. Est-ce l'avenir des paiements, ou les stablecoins ne sont-ils qu'une tendance éphémère?

-

-

- Les prix XRP augmentent au milieu des tensions du marché: un rallye de jeton à surveiller

- Jun 24, 2025 at 07:26 pm

- XRP défie les tensions géopolitiques avec un rallye de prix notable, alimenté par le retour du co-fondateur et de forts indicateurs techniques. Est-ce le début de quelque chose de grand?

-

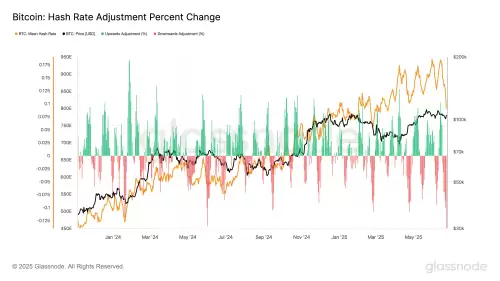

- Difficulté minière de la BTC et blockchain: naviguer dans le paysage de juillet 2024

- Jun 24, 2025 at 07:45 pm

- Un aperçu des ajustements de difficulté d'extraction de Bitcoin, des innovations de blockchain comme Fiusd Stablecoin de Fiserv et les tendances façonnant le monde de la cryptographie en juillet 2024.

-

- Moyen-Orient, sécurité financière et crise internationale: naviguer dans la volatilité

- Jun 24, 2025 at 07:10 pm

- Les tensions au Moyen-Orient créent des ondulations mondiales, ayant un impact sur la sécurité financière et le déclenchement de la crise internationale. Apprenez comment ces événements se déroulent.

-