|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

MolE : un modèle de transformateur pour l'apprentissage des graphes moléculaires

Nov 12, 2024 at 06:04 pm

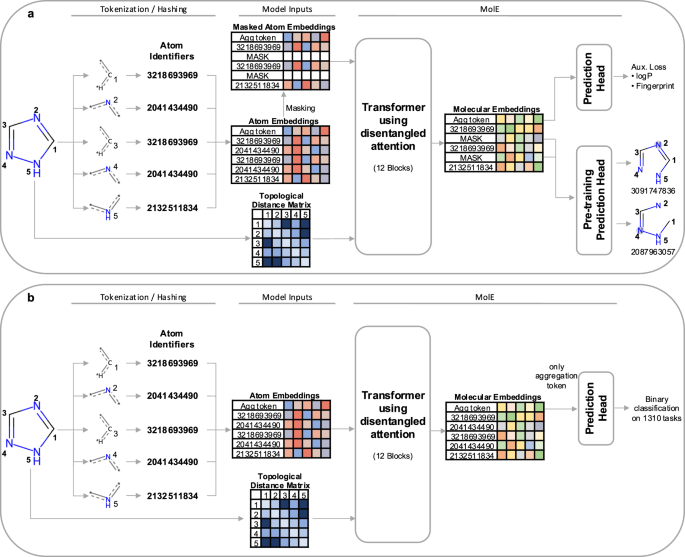

présentez MolE, un modèle basé sur un transformateur pour l'apprentissage des graphes moléculaires. MolE fonctionne directement avec les graphiques moléculaires en fournissant à la fois des identifiants d'atomes et une connectivité graphique sous forme de jetons d'entrée. Les identifiants d'atomes sont calculés en hachant différentes propriétés atomiques en un seul entier, et la connectivité graphique est donnée sous la forme d'une matrice de distance topologique. MolE utilise un Transformer comme architecture de base, qui a également été appliquée aux graphiques auparavant. Les performances des transformateurs peuvent être attribuées en grande partie à l’utilisation intensive du mécanisme d’auto-attention. Dans les transformateurs standard, les jetons d'entrée sont intégrés dans des requêtes, des clés et des valeurs \(Q,K,V\in {R}^{N\times d}\), qui sont utilisées pour calculer l'auto-attention comme :

MolE is a transformer model designed specifically for molecular graphs. It directly works with graphs by providing both atom identifiers and graph connectivity as input tokens and relative position information, respectively. Atom identifiers are calculated by hashing different atomic properties into a single integer. In particular, this hash contains the following information:

MolE est un modèle de transformateur conçu spécifiquement pour les graphiques moléculaires. Il fonctionne directement avec les graphiques en fournissant à la fois des identifiants d'atomes et une connectivité graphique sous forme de jetons d'entrée et d'informations de position relative, respectivement. Les identifiants d'atomes sont calculés en hachant différentes propriétés atomiques en un seul entier. Ce hachage contient notamment les informations suivantes :

- number of neighboring heavy atoms,

- nombre d'atomes lourds voisins,

- number of neighboring hydrogen atoms,

- nombre d'atomes d'hydrogène voisins,

- valence minus the number of attached hydrogens,

- valence moins le nombre d'hydrogènes attachés,

- atomic charge,

- la charge atomique,

- atomic mass,

- la masse atomique,

- attached bond types,

- les types d'obligations attachées,

- and ring membership.

- et l'adhésion au ring.

Atom identifiers (also known as atom environments of radius 0) were computed using the Morgan algorithm as implemented in RDKit.

Les identifiants d'atomes (également appelés environnements d'atomes de rayon 0) ont été calculés à l'aide de l'algorithme de Morgan tel qu'implémenté dans RDKit.

In addition to tokens, MolE also takes graph connectivity information as input which is an important inductive bias since it encodes the relative position of atoms in the molecular graph. In this case, the graph connectivity is given as a topological distance matrix d where dij corresponds to the length of the shortest path over bonds separating atom i from atom j.

En plus des jetons, MolE prend également en entrée les informations de connectivité du graphe, ce qui constitue un biais inductif important puisqu'il code la position relative des atomes dans le graphe moléculaire. Dans ce cas, la connectivité du graphe est donnée sous la forme d'une matrice de distance topologique d où dij correspond à la longueur du chemin le plus court sur les liaisons séparant l'atome i de l'atome j.

MolE uses a Transformer as its base architecture, which also has been applied to graphs previously. The performance of transformers can be attributed in large part to the extensive use of the self-attention mechanism. In standard transformers, the input tokens are embedded into queries, keys and values \(Q,K,V\in {R}^{N\times d}\), which are used to compute self-attention as:

MolE utilise un Transformer comme architecture de base, qui a également été appliquée aux graphiques auparavant. Les performances des transformateurs peuvent être attribuées en grande partie à l’utilisation intensive du mécanisme d’auto-attention. Dans les transformateurs standard, les jetons d'entrée sont intégrés dans des requêtes, des clés et des valeurs \(Q,K,V\in {R}^{N\times d}\), qui sont utilisées pour calculer l'auto-attention comme :

where \({H}_{0}\in {R}^{N\times d}\) are the output hidden vectors after self-attention, and \(d\) is the dimension of the hidden space.

où \({H}_{0}\in {R}^{N\times d}\) sont les vecteurs cachés de sortie après auto-attention, et \(d\) est la dimension de l'espace caché.

In order to explicitly carry positional information through each layer of the transformer, MolE uses the disentangled self-attention from DeBERTa:

Afin de transmettre explicitement les informations de position à travers chaque couche du transformateur, MolE utilise l'auto-attention démêlée de DeBERTa :

where \({Q}^{c},{K}^{c},{V}^{c}\in {R}^{N\times d}\) are context queries, keys and values that contain token information (used in standard self-attention), and \({Q}_{i,j}^{p},{K}_{i,j}^{p}\in {R}^{N\times d}\) are the position queries and keys that encode the relative position of the \(i{{{\rm{th}}}}\) atom with respect to the \(j{{{\rm{th}}}}\) atom. The use of disentangled attention makes MolE invariant with respect to the order of the input atoms.

où \({Q}^{c},{K}^{c},{V}^{c}\in {R}^{N\times d}\) sont des requêtes contextuelles, des clés et des valeurs contenant un jeton informations (utilisées dans l'auto-attention standard), et \({Q}_{i,j}^{p},{K}_{i,j}^{p}\in {R}^{N\times d}\) sont les requêtes de position et les clés qui codent le position relative de l'atome \(i{{{\rm{th}}}}\) par rapport à l'atome \(j{{{\rm{th}}}}\). L'utilisation de l'attention démêlée rend MolE invariant par rapport à l'ordre des atomes d'entrée.

As mentioned earlier, self-supervised pretraining can effectively transfer information from large unlabeled datasets to smaller datasets with labels. Here we present a two-step pretraining strategy. The first step is a self-supervised approach to learn chemical structure representation. For this we use a BERT-like approach in which each atom is randomly masked with a probability of 15%, from which 80% of the selected tokens are replaced by a mask token, 10% replaced by a random token from the vocabulary, and 10% are not changed. Different from BERT, the prediction task is not to predict the identity of the masked token, but to predict the corresponding atom environment (or functional atom environment) of radius 2, meaning all atoms that are separated from the masked atom by two or less bonds. It is important to keep in mind that we used different tokenization strategies for inputs (radius 0) and labels (radius 2) and that input tokens do not contain overlapping data of neighboring atoms to avoid information leakage. This incentivizes the model to aggregate information from neighboring atoms while learning local molecular features. MolE learns via a classification task where each atom environment of radius 2 has a predefined label, contrary to the Context Prediction approach where the task is to match the embedding of atom environments of radius 4 to the embedding of context atoms (i.e., surrounding atoms beyond radius 4) via negative sampling. The second step uses a graph-level supervised pretraining with a large labeled dataset. As proposed by Hu et al., combining node- and graph-level pretraining helps to learn local and global features that improve the final prediction performance. More details regarding the pretraining steps can be found in the Methods section.

Comme mentionné précédemment, le pré-entraînement auto-supervisé peut transférer efficacement des informations de grands ensembles de données non étiquetés vers des ensembles de données plus petits avec des étiquettes. Nous présentons ici une stratégie de pré-formation en deux étapes. La première étape est une approche auto-supervisée pour apprendre la représentation de la structure chimique. Pour cela nous utilisons une approche de type BERT dans laquelle chaque atome est masqué aléatoirement avec une probabilité de 15%, dont 80% des jetons sélectionnés sont remplacés par un jeton de masque, 10% remplacés par un jeton aléatoire du vocabulaire, et 10% ne sont pas modifiés. Différent de BERT, la tâche de prédiction n'est pas de prédire l'identité du jeton masqué, mais de prédire l'environnement atomique correspondant (ou environnement atomique fonctionnel) de rayon 2, c'est-à-dire tous les atomes séparés de l'atome masqué par deux liaisons ou moins. . Il est important de garder à l’esprit que nous avons utilisé différentes stratégies de tokenisation pour les entrées (rayon 0) et les étiquettes (rayon 2) et que les jetons d’entrée ne contiennent pas de données superposées sur les atomes voisins afin d’éviter les fuites d’informations. Cela incite le modèle à regrouper les informations des atomes voisins tout en apprenant les caractéristiques moléculaires locales. MolE apprend via une tâche de classification dans laquelle chaque environnement atomique de rayon 2 a une étiquette prédéfinie, contrairement à l'approche de prédiction de contexte où la tâche consiste à faire correspondre l'intégration des environnements atomiques de rayon 4 à l'intégration des atomes de contexte (c'est-à-dire les atomes environnants au-delà). rayon 4) par échantillonnage négatif. La deuxième étape utilise un pré-entraînement supervisé au niveau graphique avec un grand ensemble de données étiquetées. Comme proposé par Hu et al., la combinaison du pré-entraînement au niveau des nœuds et des graphes permet d'apprendre des fonctionnalités locales et globales qui améliorent les performances de prédiction finale. Plus de détails concernant les étapes de pré-formation peuvent être trouvés dans la section Méthodes.

MolE was pretrained using an ultra-large database of ~842 million molecules from ZINC and ExCAPE-DB, employing a self-supervised scheme (with an auxiliary loss) followed by a supervised pretraining with ~456K molecules (see Methods section for more details). We assess the quality of the molecular embedding by finetuning MolE on a set of downstream tasks. In this case, we use a set of 22 ADMET tasks included in the Therapeutic Data Commons (TDC) benchmark This benchmark is composed of 9 regression and 13 binary classification tasks on datasets that range from hundreds (e.g, DILI with 475 compounds) to thousands of compounds (such as CYP inhibition tasks with ~13,000 compounds). An advantage of using this benchmark is

MolE a été pré-entraîné à l'aide d'une base de données ultra-large d'environ 842 millions de molécules de ZINC et ExCAPE-DB, en utilisant un schéma auto-supervisé (avec une perte auxiliaire) suivi d'un pré-entraînement supervisé avec environ 456 000 molécules (voir la section Méthodes pour plus de détails) . Nous évaluons la qualité de l'intégration moléculaire en affinant MolE sur un ensemble de tâches en aval. Dans ce cas, nous utilisons un ensemble de 22 tâches ADMET incluses dans le benchmark Therapeutic Data Commons (TDC). Ce benchmark est composé de 9 tâches de régression et 13 tâches de classification binaire sur des ensembles de données allant de centaines (par exemple, DILI avec 475 composés) à des milliers. de composés (telles que les tâches d'inhibition du CYP avec environ 13 000 composés). Un avantage de l’utilisation de ce benchmark est

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

- Vitalik Buterin repense l'avenir d'Ethereum : les L2 évoluent au-delà des fragments à mesure qu'Ethereum évolue

- Feb 04, 2026 at 12:15 pm

- Les dernières idées de Vitalik Buterin redéfinissent le rôle des L2, en déplaçant l'attention des fragments vers diverses fonctionnalités à mesure que le réseau principal d'Ethereum évolue.

-

- Ozak AI alimente l’expansion du réseau avec des simulations de croissance et envisage des cotations majeures en bourse

- Feb 04, 2026 at 11:48 am

- Les simulations de croissance innovantes d'Ozak AI et ses efforts stratégiques d'expansion du réseau le positionnent pour avoir un impact significatif sur le marché, attirant une attention majeure des échanges.

-

- Des coffres-forts numériques aux rues de Téhéran : vols, manifestations et larmes invisibles d’un monde en mutation

- Feb 04, 2026 at 08:34 am

- Les événements récents révèlent un monde aux prises avec des « vols », des braquages physiques de crypto-monnaies au pillage économique, alimentant les « protestations » et les « larmes » invisibles dans divers paysages.

-

- La marche sur la corde raide du Bitcoin : naviguer dans la crise du crédit aux États-Unis et le gonflement de la dette

- Feb 04, 2026 at 08:17 am

- La récente baisse du Bitcoin n’est pas qu’un incident ; il s'agit d'une plongée profonde dans les courants complexes des conditions de crédit aux États-Unis et de l'endettement croissant, signalant un moment charnière pour le roi de la cryptographie.

-

- WisdomTree envisage la rentabilité de la cryptographie alors que la finance traditionnelle adopte l'innovation en chaîne

- Feb 04, 2026 at 07:43 am

- Les projets de cryptographie de WisdomTree sont proches de la rentabilité, signalant un changement majeur dans l'engagement de la gestion d'actifs traditionnelle envers les actifs numériques et la technologie blockchain.

-

- Big Apple Bit : le rebond de Bitcoin cache une plongée plus profonde, disent les observateurs de la vague 3

- Feb 04, 2026 at 06:00 am

- Bitcoin connaît un rebond prudent, mais des analystes avisés préviennent qu'il ne s'agit que d'un arrêt sur une trajectoire de crash plus profonde de la troisième vague d'Elliott, testant la résilience du marché et les nerfs des investisseurs.

-

- Les DeFi Vaults sont prêts pour le boom de 2026 : l'infrastructure arrive à maturité, l'optimisation du rendement et les préférences en matière de liquidité façonnent l'avenir

- Feb 04, 2026 at 05:59 am

- Plongez dans l’avenir des coffres-forts, des infrastructures et des stratégies de rendement DeFi à l’approche de 2026, en mettant en évidence les tendances clés et l’adoption institutionnelle.

-

- La Monnaie royale canadienne dévoile son « Gold Dime » avec une valeur étonnante et des collectionneurs captivants

- Feb 04, 2026 at 05:47 am

- La Monnaie royale canadienne présente une superbe pièce en or pur ressemblant à une pièce de dix cents, mais affichant une valeur nominale de 200 $ et un prix élevé, captivant les collectionneurs.

-

- Datavault AI se lance dans les objets de collection numériques avec Dream Bowl Meme Coin II, naviguant dans le Far West du Web3

- Feb 04, 2026 at 05:03 am

- La distribution Dream Bowl Meme Coin II de Datavault AI marque une incursion d'entreprise dans le monde volatile et narratif des objets de collection numériques, alliant récompenses pour les actionnaires et engagement Web3.

![[4K 60fps] Roses par ADepressedBean (1 pièce) [4K 60fps] Roses par ADepressedBean (1 pièce)](/uploads/2026/02/04/cryptocurrencies-news/videos/origin_698295b230e71_image_500_375.webp)